Magnífico artículo acerca del Calentamiento Global publicado por AEMET. AUTORES: Asún Pastor, Delia Gutierrez y Rubén del Campo.

Magnífico artículo acerca del Calentamiento Global publicado por AEMET. AUTORES: Asún Pastor, Delia Gutierrez y Rubén del Campo.

Divulgación por Meteosojuela.

¿A qué nos referimos cuando hablamos de la temperatura global?

Quién no ha oído hablar del calentamiento global o del cambio climático, tal vez incluso le ha entrado vértigo al ver las gráficas que nos muestran el pronunciado aumento de la temperatura del planeta. Como apunta la Organización Meteorológica Mundial (OMM), de los 17 años más cálidos desde 1880, 16 se sitúan en el siglo XXI, habiéndose encadenado cuatro años de temperaturas récord. En esto consiste el calentamiento global. Vamos a tratar de mostrar qué entendemos por temperatura global y cómo se estima a partir de las observaciones disponibles, en la actualidad, en los últimos 100-150 años, y en épocas más lejanas, paleoclimáticas. Hay que subrayar que la comprensión de los cambios climáticos del pasado es esencial para la previsión de los climas del futuro.

Quién no ha oído hablar del calentamiento global o del cambio climático, tal vez incluso le ha entrado vértigo al ver las gráficas que nos muestran el pronunciado aumento de la temperatura del planeta. Como apunta la Organización Meteorológica Mundial (OMM), de los 17 años más cálidos desde 1880, 16 se sitúan en el siglo XXI, habiéndose encadenado cuatro años de temperaturas récord. En esto consiste el calentamiento global. Vamos a tratar de mostrar qué entendemos por temperatura global y cómo se estima a partir de las observaciones disponibles, en la actualidad, en los últimos 100-150 años, y en épocas más lejanas, paleoclimáticas. Hay que subrayar que la comprensión de los cambios climáticos del pasado es esencial para la previsión de los climas del futuro.

La temperatura global

En primer lugar, vamos a centrarnos en el concepto, esto es, si tiene sentido hablar de la temperatura a escala planetaria o global. Nuestra fuente básica de información ha sido http://www.climat-en-questions.fr/reponse/evolution-actuelle/temperature-globale-par-alexis-hannart. Alexis Hannart es un investigador del Instituto Franco-Argentino de Estudios del Clima y de sus Impactos (IFAECI), un laboratorio internacional del Centro Nacional de Investigaciones Científicas (CNRS, de sus siglas en francés) con sede en Buenos Aires. Su principal tema de investigación se refiere a la detección y atribución del cambio climático, cuya finalidad es poner en evidencia los lazos de causalidad eventuales entre las respuestas climáticas observadas (tendencias a largo plazo o eventos puntuales) y los forzamientos externos (naturales o antropogénicos), para lo cual desarrolla una serie de métodos estadísticos.

Somos conscientes de la gran variedad de climas existentes en la Tierra. Así, hay una media de -20°C en Groenlandia, +25°C en el Sahara y +10°C en nuestras latitudes. Cuando se calcula una media de todos estos valores locales de la temperatura en todos los puntos del globo, se obtiene un valor global de 14°C. Llegados aquí, no resulta extraño preguntarse acerca del sentido y de la pertinencia de este valor. En efecto, contrariamente a la temperatura que hace en la habitación en la que os encontráis en este instante, que se define de forma precisa en términos físicos, la temperatura global no corresponde a una realidad inmediata, local y perceptible, en la medida en que se trata de una media, es decir, de una magnitud estadística y no física, o sea, de un índice que agrega muchas informaciones diferentes. Por tanto, en sentido estricto, es un abuso del lenguaje hablar de temperatura global de la Tierra, puesto que ningún termómetro la mide. En rigor, se debería hablar del índice de temperatura global. Sin embargo, a pesar de este ligero abuso de lenguaje, la temperatura global tiene claramente un sentido y una utilidad, como vamos a tratar de mostrar.

En climatología, el uso de tales índices de media es sistemático y universal. De hecho, la noción de clima en un lugar dado del globo viene definida como la media en el transcurso del tiempo de numerosas situaciones meteorológicas, a veces con gran contraste, que se suceden en este lugar. El clima es, por tanto, intrínsecamente una noción estadística y por consiguiente, clima y media son inseparables. Por tanto, afirmar que calcular las medias de las temperaturas no tiene ningún sentido sería lo mismo que afirmar que la noción de clima carece de sentido. Sin embargo, las nociones de media y de clima tienen un sentido y una utilidad que es bastante fácil de percibir intuitivamente. Desde un punto de vista práctico, en primer lugar, cuando se afirma que, por ejemplo, el clima de Asturias es más húmedo que el clima mediterráneo, todo el mundo comprende bien que se habla de una situación media, y que ocasionalmente, en Asturias puede haber más sequedad que en Murcia, y que esta media tiene un sentido general que resulta fácil de conectar con una realidad vivida. Desde un punto de vista más científico, los valores medios pueden también dar lugar a una interpretación física. Así, la temperatura global de la Tierra es la temperatura de equilibrio radiativo. Existe una ley física denominada ley de Stefan-Botzmann que establece una relación matemática entre la temperatura y la cantidad de energía emitida por radiación. Aplicando esta ley, podemos dar a la temperatura global de 14°C una interpretación en términos de balance radiativo y, por extensión, tener una idea de la modificación de esta temperatura (el calentamiento climático) cuando el balance radiativo es perturbado por la actividad humana (las emisiones de gases de efecto invernadero). Este tipo de interpretaciones no se limitan a nuestro planeta sino que son también aplicables a otros planetas del sistema solar, incluso a otros cuerpos celestes. A efectos de comparación: los astrónomos calculan usualmente temperaturas globales para toda clase de objetos, en ocasiones bastante más pesados que la Tierra, a partir de la energía radiada. La temperatura global media de la superficie del Sol así obtenida es de 5500°C, la de Marte de 60°C, y la de Venus de 460°C: estos valores son índices globales promediados de temperatura tras los cuales pueden existir variaciones locales importantes, pero que sin embargo, nos permiten caracterizar el clima que reina en estos planetas. Finalmente, volviendo a la Tierra, la temperatura global no es más que un indicador descriptivo entre otros muchos que, tomado aisladamente, resulta completamente insuficiente, pero esto no impide que tenga un sentido y una pertinencia.

Independientemente de la cuestión del sentido y de la pertinencia de la temperatura global, resulta legítimo preguntarse si esta cifra puede en la práctica calcularse con un nivel de fiabilidad correcto. La respuesta a esta cuestión es positiva. Sin que ello signifique que este cálculo sea sencillo, tanto desde el punto de vista técnico como conceptual. De hecho, cuando se aborda el problema de la determinación de este valor, uno se enfrenta a múltiples dificultades. En efecto, las lecturas de temperatura que deben agregarse en una media global proceden de diferentes fuentes. En los continentes, se trata de datos procedentes de varios millones de estaciones meteorológicas operadas por los servicios meteorológicos nacionales. Estos servicios utilizan con frecuencia instrumentos y procedimientos de recogida que difieren de un país al otro y que han evolucionado en el transcurso del tiempo. De manera similar, la densidad espacial de las redes de estaciones difiere de una zona a otra y también ha evolucionado en el transcurso del tiempo. Paralelamente, las lecturas de la temperatura de la superficie del mar se obtienen a partir de instrumentos de medida embarcados en boyas, sobre barcos científicos o comerciales y, desde los años 80, también en satélites meteorológicos. En este último caso, la temperatura de la superficie se mide indirectamente, a partir de la radiación terrestre emitida, que es registrada por los sensores del satélite, los cuales pueden variar de una generación de satélites a otra.

En consecuencia, se percibe bien que la dificultad principal de cálculo de la temperatura media global reside en la agregación de numerosos datos, de orígenes múltiples y cambiantes. Para resolver esta dificultad, se utilizan en ocasiones complejos procedimientos estadísticos. Nos podemos preguntar, por tanto, acerca de la fiabilidad de estos procedimientos. ¿Pueden afectar de una forma sustancial a la evaluación hecha de la temperatura global, y por tanto, del calentamiento climático? Para responder a estas interrogaciones legítimas, es importante subrayar que estos procedimientos se apoyan en un cuadro conceptual probado, que ha sido ideado por matemáticos hace más de un siglo, precisamente con el fin de poder cuantificar la incertidumbre introducida en un cálculo complejo de este tipo, realizado a partir de observaciones diversas y que adolecen de errores. Este marco conceptual es el de la estadística, y se funda en la teoría de las probabilidades. La utilización de este marco permite en esencia obtener no solamente una cifra, sino también un margen de error – a menudo denominado intervalo de confianza– que proporciona una indicación del nivel de fiabilidad del resultado. En particular, el problema consistente en agregar un gran número de datos heterogéneos en una media o una suma global ya ha sido ampliamente tratado porque se presenta de forma similar en múltiples ramas de la ciencia. En economía por ejemplo, el cálculo del PIB de un país y de su crecimiento, indicadores cumulativos fáciles de comprender y universalmente utilizados, es sin embargo de una complejidad y tecnicismo elevado. Notemos por otra parte, que los márgenes de error del PIB y el crecimiento se comunican muy poco, en comparación con otras ciencias -entre las que se encuentran las del clima- en las que la comunicación de las barras de error está mucho más extendida-. A pesar de su importancia en economía, raras son las personas que se alarman por su ausencia en este dominio.

Pues bien, aunque es difícil de obtener una estimación precisa del valor absoluto de la temperatura media global, sus variaciones en el transcurso de las últimas décadas pueden en cambio ser estimadas con una buena precisión. Así, la temperatura media absoluta en el periodo 1961-1990 se estima que sea 14°C, con un margen de error de +-0.5°C pero la estimación de la diferencia entre la temperatura media en 2010 y la de este periodo de referencia se eleva a +0.53°C con un margen de error de +-0.09°C. El margen de error de la segunda es inferior en un factor de cinco con respecto a la primera, y es suficientemente débil para poder afirmar que el planeta se ha calentado en este periodo. Por otra parte, un cambio de muy pocos grados en la temperatura media global del planeta tiene un gran impacto en el medio.

Para terminar y a modo de resumen, el cálculo de la temperatura media y de sus variaciones así como la cuantificación de la incertidumbre asociada es, por tanto, un problema complejo, pero se encuentran disponibles procedimientos rigurosos para tratarla, permitiendo controlar la fiabilidad del resultado.

Observaciones modernas

Antes de abordar la forma de cálculo, nos detendremos en los diferentes tipos de observaciones que, grosso modo, podríamos clasificar en: datos de estaciones en tierra, datos de satélite y datos de indicadores paleoclimáticos (o proxies).

Los estudiosos del clima utilizan cualquier medida disponible, ya sea directa o indirecta, para estudiar la historia del clima de la Tierra, desde las últimas observaciones procedentes de satélite y de estaciones de superficie, hasta las muestras de hielo prehistórico extraídas de los glaciares. En conjunto, estos datos ofrecen una visión global de la variabilidad y de los cambios a largo plazo de la atmósfera, del océano, de la criosfera y de la superficie de las tierras emergidas.

Cuando se centran en los cambios que han tenido lugar en los últimos 100-150 años, utilizan las observaciones hechas con los instrumentos científicos modernos. Aunque el termómetro de mercurio y el barómetro se inventaron en el siglo XVII, estos y otros instrumentos modernos no se utilizaron de manera generalizada en las observaciones meteorológicas hasta mucho más tarde.

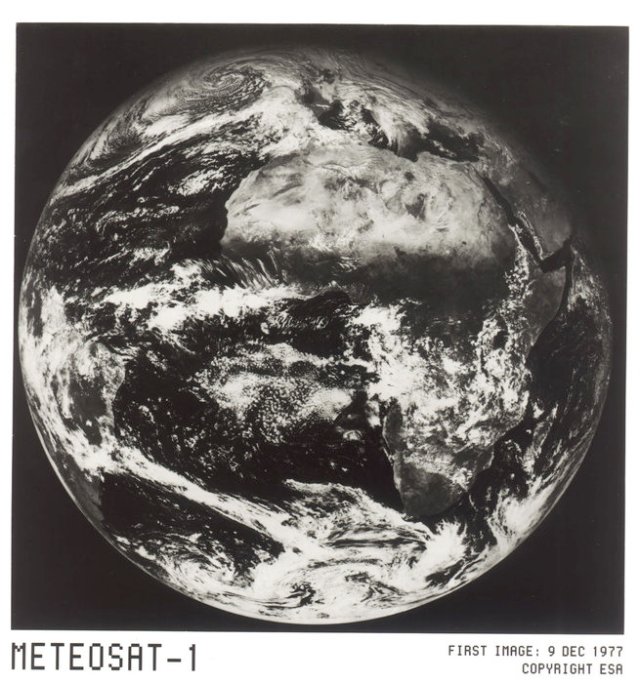

En consecuencia, antes de la puesta en marcha de los satélites, los meteorólogos dependían de las observaciones en superficie, en tierra y también mar, gracias a los barcos y boyas. La información aérea se limitaba a datos atmosféricos procedentes de radiosondas a bordo de globos, cometas y aeronaves. La llegada de los satélites supuso la entrada de una gran cantidad de información que, en combinación con los nuevos modelos informáticos, permitieron ofrecer análisis mejores y, en consecuencia, también pronósticos más fiables para periodos de tiempo más largos. El primer satélite de observación de la Tierra de la Agencia Espacial Europea (ESA, de sus siglas en inglés) fue lanzado el 23 de noviembre de 1977. Cuando llegó a su destino, Meteosat-1 completó la cobertura total del planeta desde una órbita geoestacionaria, sentando las bases para la cooperación meteorológica a nivel europeo y mundial, que continúa hoy en día.

Al ser capaces de ver la totalidad del planeta, los meteorólogos pueden observar el desarrollo de los sistemas meteorológicos y calcular la velocidad y la dirección de los vientos en función de los movimientos de las nubes. A pesar de que los primeros satélites meteorológicos no tenían como objetivo medir el cambio climático, las imágenes satelitales han aportado mucha información de los cambios en la cubierta terrestre o el hielo polar, así como datos de temperatura de la superficie del mar.

Los satélites no miden directamente la temperatura. Van provistos de sensores (radiómetros) que miden la energía radiante procedente de diversas fuentes emisoras que ha sufrido una serie de procesos en el sistema tierra-atmósfera. Las principales fuentes de emisión son la superficie de la Tierra, la atmósfera, las nubes y las zonas acuosas (mares, océanos, lagos, ríos, etc.). Los datos de satélites cubren prácticamente todo el globo terráqueo con una buena precisión.

Registros paleoclimáticos

Cuando los investigadores se centran en el clima del periodo anterior a los últimos 100-150 años, utilizan registros procedentes de materiales físicos, químicos y biológicos preservados en el interior del registro geológico. Estos indicadores paleoclimáticos son registros locales cuya interpretación, basada en principios físicos y biofísicos, permite representar un conjunto de variaciones relacionadas con el clima en tiempos pasados. Algunos ejemplos de indicadores paleoclimáticos (o proxies) son: el análisis del polen, el estudio del crecimiento de los anillos de los árboles, las características de los corales o ciertos datos obtenidos a partir de sedimentos marinos y testigos de hielo.

Tomados en conjunto, estos indicadores extienden nuestro conocimiento del clima pasado a cientos de millones de años atrás (véase https://climate.nasa.gov/faq/34/what-kinds-of-data-do-scientists-use-to-study-climate/). Los registros globales fiables del clima solo se iniciaron en la década de 1880, y estos paleoindicadores constituyen el único medio científico para determinar los patrones climáticos antes de que comenzara el mantenimiento de registros directos por el ser humano.

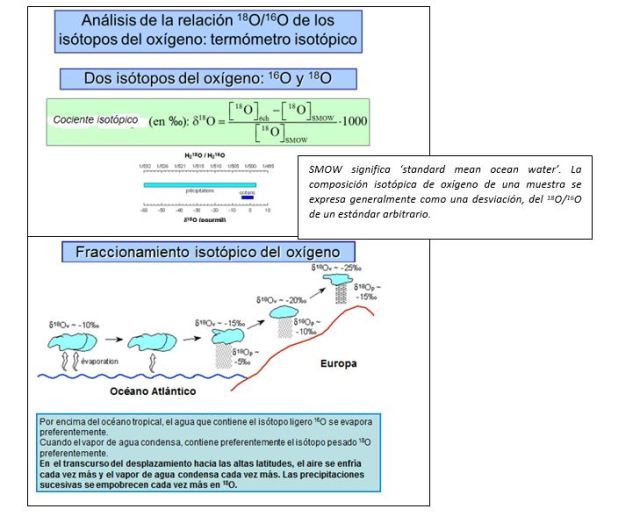

Un “proxy” o paleoindicador es, por ejemplo, la proporción de distintos isótopos de oxígeno:

|

- Las masas de aire que se mueven de los trópicos a las latitudes altas tienen una proporción menor de 18O respecto a 16O ya que la condensación elimina el 18O en primer lugar y el vapor de agua queda enriquecido en 16

- La proporción de 18O respecto de 16O depende de la temperatura de la siguiente forma: Conforme el clima es más cálido, los organismos en el océano que utilizan oxígeno en la secreción de sus esqueletos (p.ej., CaCO3) secretan más 18O porque el 16O, más ligero se ha evaporado.

Se ha comprobado que las variaciones de la relación oxígeno 18O/16O en las conchas de foraminíferos concuerdan razonablemente con las variaciones previstas de insolación inducidas por los cambios cíclicos de los parámetros orbitales de la Tierra y con las consiguientes fluctuaciones climáticas pronosticadas por la teoría de Milankovitch. Cuanto más débil es el valor de δ18O del hielo, más frío hacía en el momento de su formación, mientras que un aumento del δ18O del hielo corresponde a un aumento de temperatura. La correlación entre temperatura y composición isotópica también permite identificar el hielo depositado durante los períodos glaciales, debido a que tiene una concentración muy reducida de isótopos pesados en relación con la precipitación de épocas más recientes.

El cálculo de la temperatura global

Una vez descritas, aunque sea someramente, el tipo de observaciones que se manejan en meteorología y climatología, nos surge la pregunta de cómo podemos hablar de temperatura del planeta cuando sólo se disponía de un número limitado de estaciones meteorológicas y, en el mejor de los casos, concentradas en Europa y América del Norte. En esencia, la respuesta consiste en hallar una climatología global o planetaria de referencia (Jones et al. 2012), construyendo una rejilla global o planetaria observacional. Los nuevos datos en rejilla regular de 5º x 5º (longitud-latitud), aproximadamente unos 500 km x 500 km se basan en un archivo de temperaturas medias mensuales proporcionadas por más de 5500 estaciones meteorológicas distribuidas alrededor del mundo. La temperatura de una estación dada se convierte en anomalía respecto a la temperatura promedio del periodo 1961-90 de esa estación, y el valor correspondiente a una celdilla de la rejilla se obtiene como la media de todas las anomalías de las estaciones de observación que caen dentro de la celdilla. Al igual que la anomalía media, se proporcionan estimaciones de las incertidumbres que surgen de la precisión del termómetro, de la homogeneización, del muestreo de las celdillas de la rejilla cuando se dispone de un número finito de medidas, de los sesgos a gran escala como la progresiva urbanización del terreno y de la estimación de los promedios regionales con una cobertura de medidas globales no completa.

Por último, se calculan las series temporales hemisféricas promedio (Jones, 1994). Los promedios se calculan para cada mes desde enero de 1850, y luego los promedios estacionales y anuales se calculan utilizando los valores mensuales promedios hemisféricos. Se utilizan las estaciones estándar de tres meses, esto es, primavera (MAM), verano (JJA), otoño (SON) e invierno (DEF) tomándose, en el caso del invierno, el mes de diciembre del año anterior, enero y febrero del actual. Como diciembre de 1849 no se encontraba disponible, todas las series anuales y estacionales comienzan en 1851 para el hemisferio norte. En el hemisferio sur, el primer año es 1856. Antes de esta fecha, había menos de 5 estaciones con datos.

Los conjuntos de datos

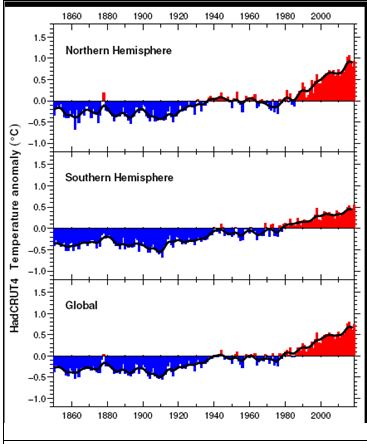

HadCRUT4 es un conjunto de datos de temperatura global, que proporciona anomalías de temperatura en una rejilla global así como promedios para los hemisferios y el globo como conjunto. CRUTEM4 y HadSST3 son las componentes de tierra y oceánica de este conjunto global. Estos conjuntos de datos han sido elaborados por la Climatic Research Unit (Universidad de East Anglia, UK) en colaboración con el Hadley Centre (UK Met Office). Por lo que respecta al conjunto de datos de la temperatura de la superficie del mar (SST), ha sido desarrollado en exclusividad por el Hadley Centre. Estos conjuntos de datos se actualizarán a intervalos aproximadamente mensuales en el futuro. Los promedios hemisféricos y globales expresados como valores mensuales y anuales estarán disponibles como ficheros separados.

|

|

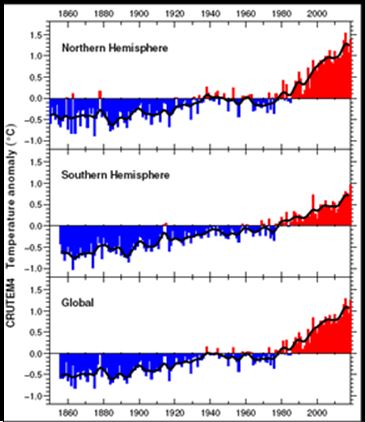

| Anomalías de temperatura anual media (HN, HS, Global). HadCRUT4 es un conjunto de datos de temperatura global. Fuente: https://crudata.uea.ac.uk/cru/data/temperature/ | Anomalías de temperatura anual media (HN, HS, Global). CRUTEM4 es un conjunto de datos de temperatura de aire sobre tierra. Fuente: https://crudata.uea.ac.uk/cru/data/temperature/ |

|

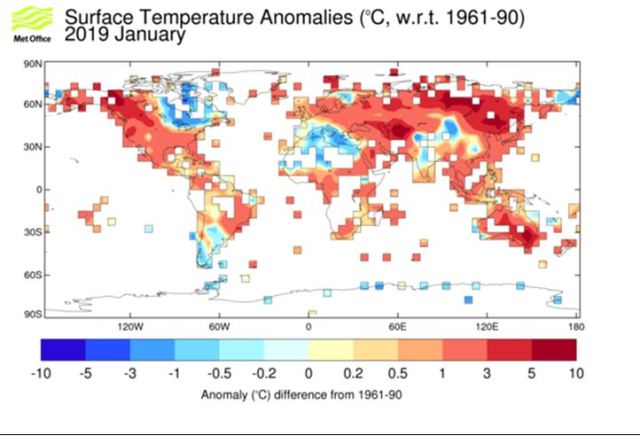

| Anomalías de la temperatura en superficie para el mes de enero de 2019 del conjunto de datos en punto de rejilla sobre tierra (CRUTEM4). Fuente: https://www.metoffice.gov.uk/hadobs/crutem4/. |

¿Qué aporta la paleoclimatología?

Las grandes redes de medidas meteorológicas permiten conocer la evolución del clima desde hace aproximadamente 150 años, que es relativamente breve o corto. Numerosos métodos han sido desarrollados por los paleoclimatólogos para estimar la evolución anterior del clima. En efecto, las variaciones de múltiples parámetros del clima dejan huella en los medios naturales. Se han elaborado métodos basados en la perforación para extraer estos archivos naturales del clima, tanto en los continentes (en los hielos polares, los sedimentos lacustres, los suelos, las estalagmitas y los troncos de árboles) como en el fondo de los océanos (en los sedimentos marinos o en los corales). Igualmente, se han desarrollado métodos cada vez más precisos para datar estos archivos y extraer una información climática rigurosa.

Ciertas características biológicas, químicas o físicas de estas muestras pueden ligarse, cuantitativamente, a las variaciones de parámetros climáticos como la temperatura, la cantidad de precipitaciones o la salinidad del agua del mar. Estas relaciones denominadas funciones de transferencia, se establecen a partir de los gradientes geográficos actuales o bien por comparación con los registros meteorológicos u oceanográficos de los últimos decenios. Resulta posible entonces estimar las variaciones pasadas de los parámetros climáticos, suponiendo que las relaciones actuales continúan siendo válidas para los climas pasados.

|

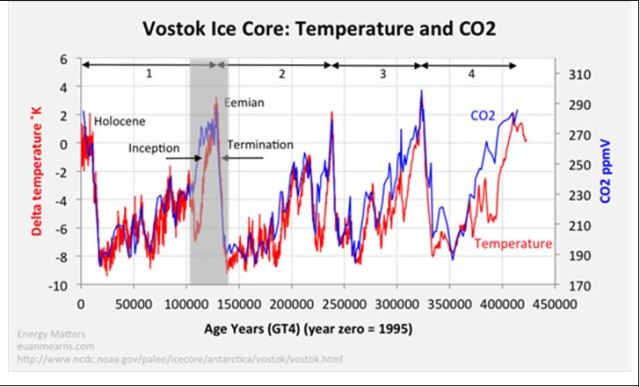

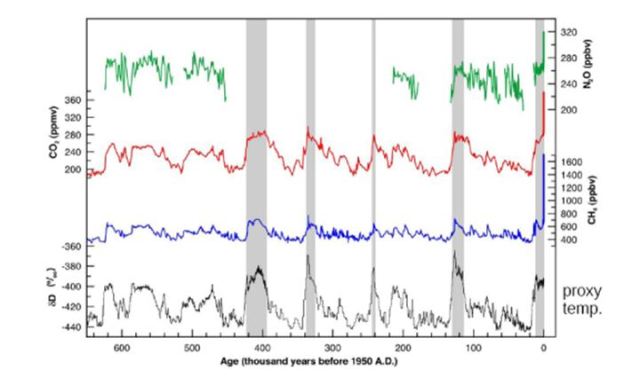

| [CO2] y relación con la T en los últimos 420.000 años. Fuente: Wikipedia |

Para ilustrar este enfoque, tomemos como ejemplo, la utilización de la abundancia de las diferentes formas de la molécula de agua (H216O, HD16O, H218O), denominados «isótopos». El vapor de agua, formado en la superficie de los océanos se encuentra empobrecido en isótopos pesados en relación al agua del mar. En las regiones templadas y polares, el enfriamiento de las masas de aire lleva consigo una condensación de vapor de agua y la pérdida preferencial de los isótopos pesados. Existe, por tanto, una relación estrecha entre la temperatura del aire y el cociente entre las formas ligeras y pesadas de las moléculas de agua presentes en las precipitaciones: cuanto más frío sea el aire, las precipitaciones se encontrarán empobrecidas en las formas pesadas de las moléculas de agua. Este «termómetro» permite entonces estimar las variaciones pasadas de la temperatura, gracias a la medida de estos cocientes isotópicos sea en precipitaciones antiguas (preservada en los hielos polares), sea en archivos indirectos de estas precipitaciones (calcita de estalagmitas, celulosa de los anillos de los árboles, calcita de los sedimentos de los lagos, etc.).

La mayor parte de los registros paleoclimáticos aportan informaciones locales, relativas al clima del emplazamiento o lugar de medida. Diferentes parámetros medidos en un mismo archivo y diferentes archivos de una misma región se combinan después en bases de datos globales, y posteriormente se aplican métodos estadísticos para estimar las variaciones climáticas de gran escala.

La paleoclimatología permite comprender las amplitudes, las velocidades y los mecanismos de los cambios climáticos pasados y la forma en que el clima reacciona a diferentes tipos de perturbaciones. Igualmente, ha revelado la capacidad del sistema climático para producir inestabilidades brutales. Las respuestas acerca de cómo fueron los climas del pasado, de si hubo o no cambios rápidos, proporcionan un contexto para evaluar posibles cambios climáticos en el futuro.

A partir de los años 1990, el estudio de los climas del pasado ha permitido caracterizar de una forma más precisa la evolución del clima a escalas que van desde el año al siglo, ya sea para el periodo histórico reciente, o para las inestabilidades del clima glaciar.

Reconstrucción de las variaciones del clima del último milenio

Ya que la amplitud de las inestabilidades glaciales no guarda proporción con las variaciones pequeñas del clima en el transcurso de los últimos milenios, se examinan con mucha atención. Ciertos archivos climáticos proporcionan acceso a informaciones estacionales. Este es el caso de los anillos anuales de crecimiento de los árboles o las estrías de crecimiento de los corales. Se han desarrollado métodos estadísticos para combinar diferentes fuentes de información y para estimar la variabilidad, año a año, de la temperatura media (anual o para estaciones específicas) a la escala de las grandes regiones (como Europa), de un hemisferio o del globo. Estas reconstrucciones sugieren fluctuaciones modestas de la temperatura media en la superficie de la Tierra (inferior a 1 C) y permiten caracterizar la estructura espacial de estos cambios. Por ejemplo, la «anomalía medieval» (episodio cálido entre los años 950 y 1200) y la «Pequeña Edad de Hielo » (episodio frío entre los años 1300 y 1850) han sido particularmente marcados en las latitudes medias y altas del hemisferio norte. Respecto al Período Cálido Medieval, algunos científicos piensan que las temperaturas más cálidas en los últimos 2000 años antes del siglo XX se registraron en este periodo. Este calentamiento permitió a los vikingos viajar más hacia el norte de lo que había sido posible anteriormente debido a la disminución del hielo marino y al hielo terrestre en el Ártico. Sin embargo, existen pruebas de que algunos lugares fueron mucho más fríos que en el presente, incluyendo el Pacífico tropical. Desde el punto de vista de un arqueólogo y antropólogo (Brian Fagan), el climatólogo y meteorólogo británico Hubert Lamb fue uno de los primeros científicos en documentar el calentamiento medieval y fue él quien acuñó el término ‘Periodo Cálido Medieval’ para referirse a esos siglos. Durante ese periodo, gran parte del hemisferio norte gozó de un clima favorable y unas excelentes cosechas, y en consecuencia se produjo una explosión demográfica en Europa. Durante esta época, los europeos construyeron catedrales. Los prolongados ciclos secos de la época medieval incidieron en la desaparición de Angkor Wat y los poblados indígenas del cañón del Chaco. Gran parte de la aridez se debió a las condiciones que acompañaron a La Niña en el Pacífico, en especial alrededor de los años 1100 a 1200.

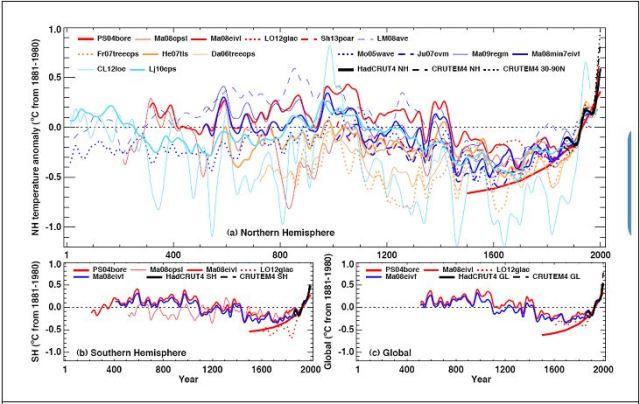

|

| Reconstrucciones recientes de la temperatura anual desde el año 1 de nuestra era (HN,HS, Global) tomadas del WG1_AR5_Chapter 5: Information from Paleoclimate Archives, pp.409 (2013) |

Los registros paleoclimáticos permiten igualmente caracterizar los factores externos (forzamientos externos) que han podido afectar a la evolución del clima en el transcurso del último milenio:

- La actividad volcánica, en particular las erupciones que inyectan partículas en la atmósfera superior, que tienen un efecto global y cuyos impactos pueden identificarse en los hielos polares de Groenlandia y de la Antártida.

- La actividad solar (gracias a los isótopos cosmogénicos producidos en la atmósfera superior y registrados en los anillos de crecimiento de los árboles y los hielos polares)

- Los cambios de uso de los suelos (deforestación y extensión de las zonas cultivadas), estimados a partir de datos arqueológicos e históricos;

- la composición atmosférica (gases de efecto invernadero y aerosoles), conocida gracias a los análisis del aire y de los aerosoles en los hielos polares.

En consecuencia, es posible simular el clima del pasado al prescribir en los modelos del clima las estimaciones de estos factores externos. Como el estado inicial del clima se conoce mal (por ejemplo, la dinámica del océano profundo hace 1000 años), los ensembles de simulaciones se realizan con diferentes estados iniciales. Estas simulaciones permiten comprender, en el marco teórico, la manera en la que los diferentes factores externos afectan al clima y cotejarlo con los datos disponibles. El análisis de los datos y de las simulaciones del último milenio muestra la importancia de la variabilidad interna climática, su respuesta a los factores naturales (vulcanismo, actividad solar, etc.) y el papel determinante de las emisiones de los gases de efecto invernadero en el calentamiento de los últimos decenios.

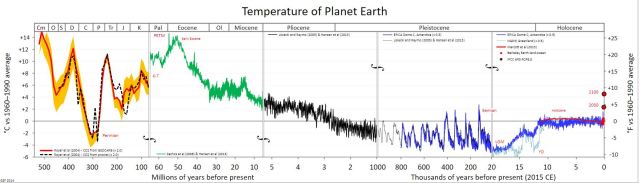

|

| Temperatura global estimada para los últimos 540 millones de años. Fuente: https://commons.wikimedia.org/wiki/File:All_palaeotemps.svg |

|

| Reconstrucción de la concentración de distintos elementos químicos relacionados con la temperatura atmosférica durante los últimos 700.000 años a partir de testigos de hielo y observaciones recientes. Fuente: IPCC, 2013. |

Comparativa de datos de temperatura global de distintas fuentes

Los registros de la temperatura global calculados por las distintas organizaciones que trabajan en la investigación climática son notablemente similares. Según las estimaciones, la temperatura media a escala global en 2018 ( OMM, Nº 1233) supera en 0,99±0,13 °C el valor de referencia que es el de la época preindustrial (1850–1900); y por tanto se dispone de evidencias de que el calentamiento global se está produciendo. Las técnicas utilizadas por el NASA’s Goddard Institute for Space Studies (GISS), el National Climatic Data Center (NCDC) y otros grupos respetados tales como el Hadley Centre/Climatic Research Unit de la Universidad de East Anglia (CRU) y el Australian Bureau of Meteorology son revisadas por pares (peer reviewed) e, igualmente, los conjuntos de datos procesados son sometidos a muchos análisis.

Una organización independiente sin ánimo de lucro llamada Berkeley Earth, financiada por becas de educación, ha elaborado sus propias técnicas de procesamiento de datos. De nuevo, los resultados son muy similares a los resultados obtenidos por el NCDC, GISS y CRU.

Epílogo

En el pasado mes de febrero, tan solo unos días antes de la muerte de Wallace S. Brocker, quien había empleado el término ‘calentamiento global’ en un artículo publicado en 1975 en el que advertía de este riesgo, la OMM alertaba de que el planeta había encadenado cuatro años de temperaturas récord a causa del cambio climático. Desde 2015, las temperaturas que ha registrado el planeta han sido las más cálidas observadas desde que existen registros, es decir, desde 1850. Tanto en la superficie terrestre como en los océanos, el ritmo al que se está produciendo este calentamiento es excepcional.

El año pasado, la temperatura del planeta fue la cuarta más elevada en más de un siglo y medio, con aproximadamente 1oC sobre la época preindustrial. Aun así, es una cifra por debajo del récord del año 2016, que estuvo marcada por el fenómeno climático de El Niño, que impulsó el registro hasta 1.2oC. En 2015 y 2017, fue de 1.1oC. La OMM cree que los datos muestran una tendencia preocupante y un ‘claro signo’ de la relación entre cambio climático a largo plazo y las concentraciones de gases de efecto invernadero. ‘La tendencia de la temperatura a largo plazo es mucho más importante que la temperatura de cada año y esa tendencia es al alza’, manifestó el secretario general de la OMM, Petteri Taalas. Según los datos recopilados por la agencia, los 20 años más cálidos de los que se tienen datos se han registrado en los últimos 22. Hoy, todos los modelos científicos concuerdan en que, al superar el umbral de 1.5 o 2oC de calentamiento, el planeta entrará en un proceso irreversible de cambio climático e inestabilidad. La OMM recordó que este 2019 ya ha comenzado con un episodio de frío extremo en Norteamérica, el enero más caluroso en Australia –con temperaturas cercanas a los 50 oC- e intensas o copiosas nevadas en los Alpes o el Himalaya. Unos eventos que se suman a los acaecidos en 2018 y que afectaron a numerosos países y a millones de personas.

‘Muchos de los fenómenos meteorológicos extremos corresponden plenamente a lo previsible en una situación de cambio climático. Se trata de una realidad a la que tenemos que hacer frente. La reducción de las emisiones y las medidas de adaptación al clima deberían gozar de máxima prioridad a nivel mundial’, dijo Taalas.

Por último, mencionar que en octubre de 2018 se aprobó el resumen del Informe Especial +1,5°C del IPCC dirigido a los que tienen que tomar decisiones. Entre los mensajes más importantes: el cambio climático es una realidad, cada medio grado de calentamiento asociado refuerza los riesgos asociados, la estabilización a +1,5°C exige reducir de una manera drástica las emisiones de CO2 y actuar igualmente sobre otras emisiones de los gases de efecto invernadero. Como afirma Valérie Masson-Delmotte, copresidente del grupo de trabajo I del IPCC, se trata de un esfuerzo histórico asociado a transiciones muy profundas de los sistemas energéticos, urbanos, industriales y de la gestión de las tierras. La ambición de contener el calentamiento a 1,5°C exigiría una actuación más temprana y más rápida que la necesaria para limitarla a 2°C. Desde el estricto punto de vista del funcionamiento intrínseco del clima, una estabilización a +1,5°C no es imposible. Y queda un gran margen de maniobra. Todo depende de las acciones que se emprendan desde hoy hasta 2030. Cualquier retraso en la acción implica un calentamiento suplementario en las próximas décadas; regresar después a +1,5°C exigiría ser capaz de extraer el CO2 de la atmósfera. Nos enfrentamos a dos grandes retos: la amplitud del esfuerzo que hay que realizar y la amplitud del riesgo.

Siguen existiendo incertidumbres y se siguen expresando de la misma forma en cada uno de los informes. En el informe especial de +1,5°C, cada conclusión se expresa con un nivel de confianza. Cada capítulo presenta los métodos de evaluación y las herramientas utilizadas, concluyendo con una sección centrada en los límites de los conocimientos disponibles actualmente. Todavía hay información limitada acerca de la cuestión del uso de la tierra y de las previsibles presiones en el uso de los suelos para producir alimento para animales y personas, así como fibras textiles y energía, que cabe esperar que se produzcan para hacer frente a las consecuencias del cambio climático. Por todas estas razones, el IPCC prepara para agosto de 2019 otro informe especial sobre este tema.

Referencias

Jones, P.D. 1994: Hemispheric surface air temperature variations: a reanalysis and an update to 1993. J. Climate 7, 1794-1802.

Jones, P.D., Lister, D.H., Osborn, T.J., Harpham, C., Salmon, M. and Morice, C. 2012: Hemispheric and large-scale surface air temperature variations: An extensive revision and an update to 2012. J. Geophys. Res. 117, D05127, doi:10.1029/2011JD017139.